(五) ATOM: Accurate Tracking by Overlap Maximization——从论文角度综述

发布日期:2021-06-18 12:11:55

浏览次数:33

分类:技术文章

本文共 3826 字,大约阅读时间需要 12 分钟。

paper: ATOM: Accurate Tracking by Overlap Maximization

文章目录

1.Motivation

现在的视觉跟踪器关注点都在功能发展强大的分类器,而忽略了更为准确地估计目标状态。现在的大多数跟踪器都是采用多尺度的搜索策略进行目标状态估计的。但是这种方法从根本上限制了跟踪器的发展,因为目标状态估计是需要关于目标的高层知识的。

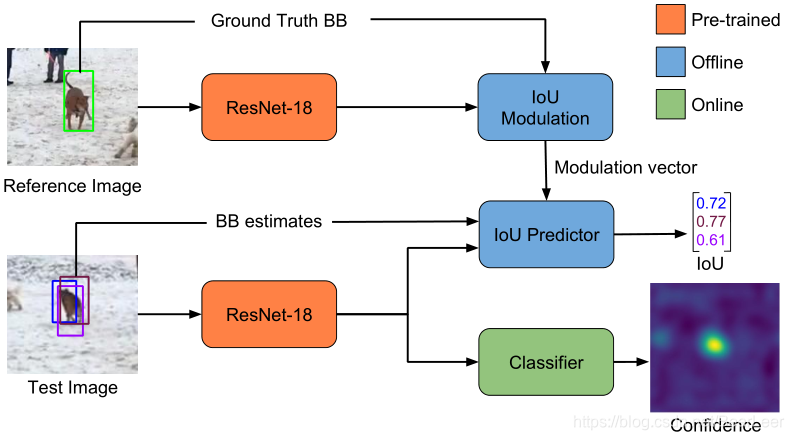

从而,作者提出了新的跟踪框架解决这一问题,该框架由目标估计和分类模块(target estimation and classification component)组成的。其一,通过大量的离线训练,目标的高层知识是融入到目标估计(target estimation)中的。训练的target estimation 是用来预测目标和估计的bbox之间的重叠率(overlap)。其二,分类模块是在线训练的,以保证较高的判别性。2.Method

作者把跟踪问题分成了分类任务(classification)和状态估计任务(estimation)。分类任务的目的是:通过将图像区域分为前景和背景,鲁棒地提供一个粗略的目标位置。状态估计任务的目的是:提供目标的状态的估计,这边用bbox表示其状态。作者在本文中的目的是消除目标分类和状态估计的性能差异。

作者整个跟踪由分类模块,状态估计模块以及模型在线更新模块构成。- (一)状态估计任务 受IoU-Net的启发,状态估计的训练是为了预测目标和预估bbox之间的IoU。然而IoU-Net是类别明确的,无法用于类别不明确的跟踪问题。从而作者提出将目标明确的信息融入到IoU预测模块中。这是通过modulation-based network实现的(基于调制的网络),将目标的外观融入到参考图像(模板帧)中去得到目标-明确的IoU估计。作者采用在大估摸数据集上的离线训练方法。

- (二)分类任务 作者的目标分类模块由2层的全卷积网络实现,并且这是在线训练的。为了保证实时性,作者采用 了共轭梯度下降方法代替了传统的梯度下降方法。

3.Train Process

状态估计是用IoU-Predictor网络实现的,该网络是在大规模数据集上离线训练的。在跟踪时,该网络参数会被冻结。其网络输入:(1)当前帧的backbone 特征; (2)当前帧的bbox状态估计;(3)模板帧的backbone特征;(4)模板帧的bbox信息。输出是:当前帧中每一个bbox的IoU得分。

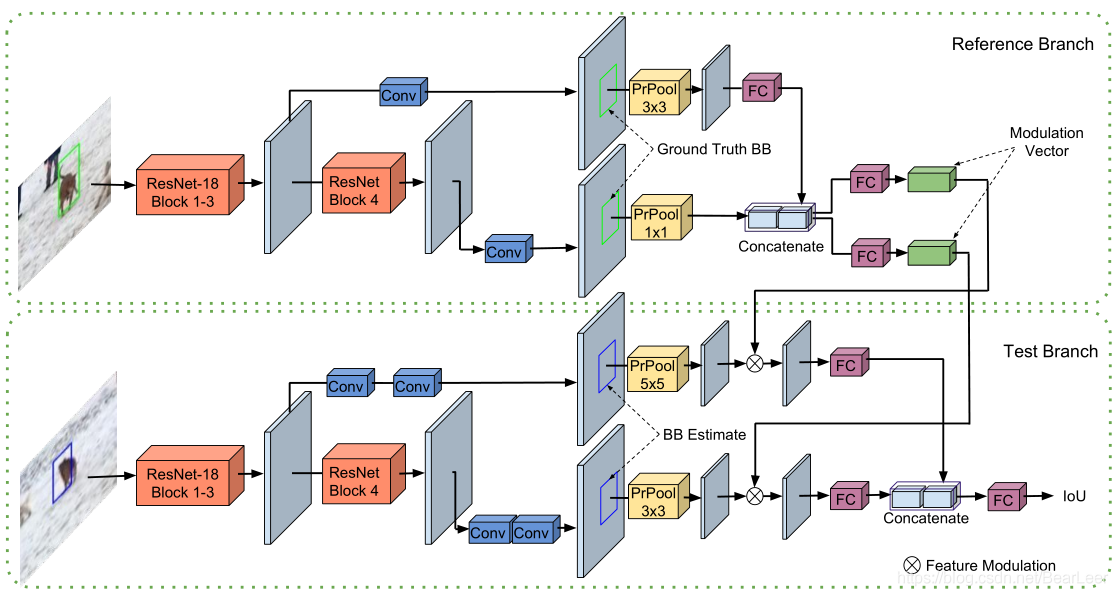

- 状态估计任务 存在的挑战是,难以有效利用模板帧的信息,从而难以构建IoU预测架构。简单的方法是:将模板帧和当前帧信息进行融合,但是会产生较差的性能。作者也发现Siamese架构会提供次最优的结果。 从而,作者提出了基于调制的网络结构(modulation-based network),该网络有2个分支,将来自ResNet-18的Block3和Block4的backbone特征作为网络的输入。 在模板帧 x 0 x_0 x0中,其输入是backbone特征 x 0 x_0 x0和标注框 B 0 B_0 B0,接着会返回一个调制向量 c ( x 0 , B 0 ) ∈ R 1 ∗ 1 ∗ D z s . t . c > 0 \mathbf{c}(x_0,B_0) \in R^{1*1*D_z} s.t. c>0 c(x0,B0)∈R1∗1∗Dzs.t.c>0。 在当前帧 x x x中,其结果的表征是 z ( x , B ) ∈ R K ∗ K ∗ D z z(x,B) \in R^{K*K*D_z} z(x,B)∈RK∗K∗Dz,K是PrPool层的输入尺度大小。接着,将调制的向量结果和表征输入到IoU predictor中,得到的预测bbox B结果如下: I o U ( B ) = g ( c ( x 0 , B 0 ) ⋅ z ( x , B ) ) \mathbf{IoU(B)}=g(c(x_0,B_0) \cdot z(x,B)) IoU(B)=g(c(x0,B0)⋅z(x,B))其中,B是通过两个PrPool预测的结果(相当于粗结果)。 训练的损失函数: l o s s = m i n ( m e a n − s q u a r e d − e r r o r ( I o U ( B ) , G T ) ) loss = min(mean-squared-error(IoU(B),GT)) loss=min(mean−squared−error(IoU(B),GT)) 训练时采用了图像对作为输入(和SiamFC一样),和DaSiamRPN图像增强方法一样,进行了训练数据的图像增强。在模板帧上,在目标正中心采用,采样区域约是目标区域的 5 2 5^2 52倍。测试图像上采样方法相同,但是加上了一定的扰动。对于每一个图像pair,产生了16个候选bbox(作为正负样本)。网络都采用了fine-tuning的方法。

-

分类任务

状态估计模块可以提供更为准确的bbox输出结果,但是缺乏鲁棒的判别性(区分前景和背景干扰物)。通过在线训练预测目标的置信得分。 分类模块由2层的全卷积网络构成,可表示为: f ( x ; w ) = ϕ 2 ( w 2 ∗ ϕ 1 ( w 1 ∗ x ) ) f(x;w)=\phi_2(w_2*\phi_1(w_1*x)) f(x;w)=ϕ2(w2∗ϕ1(w1∗x))其中,x是经过backbone 的特征图, ϕ i \phi_i ϕi代表激活函数, ∗ * ∗代表标准的多通道卷积操作。作者定义了基于 L 2 L^2 L2的损失函数。 L ( w ) = ∑ j = 1 m ∣ ∣ f ( x j ; w ) − y j ∣ ∣ 2 + ∑ k λ k ∣ ∣ w k ∣ ∣ 2 L(w)=\sum_{j=1}^m ||f(x_j;w)-y_j||^2+\sum_k \lambda_k ||w_k||^2 L(w)=∑j=1m∣∣f(xj;w)−yj∣∣2+∑kλk∣∣wk∣∣2 y j ∈ R W ∗ H y_j \in R^{W*H} yj∈RW∗H代表训练样本的特征图。 然后,作者采用了共轭梯度的下降方法实现在线训练。 -

在线跟踪模型更新方法

(1)分类模型:第一层全卷积网络: 1 ∗ 1 ∗ 64 1*1*64 1∗1∗64; 第二层全卷积网络: 4 ∗ 4 ∗ 1 4*4*1 4∗4∗1; 输出的激活函数: ϕ 2 ( t ) = t , t ≥ 0 ϕ 2 ( t ) = α ( e t α − 1 ) , t ≤ 0 \phi_2(t) = t, t \ge 0 \\ \phi_2(t) = \alpha(e^{\frac{t}{\alpha}}-1), t \le 0 ϕ2(t)=t,t≥0ϕ2(t)=α(eαt−1),t≤0 在第一帧中,做了数据增强(可参考)。然后运用了上述的共轭梯度下降法进行优化。(每隔10帧做一次优化) (2)目标状态估计模型: 应用分类模型得到了置信图,然后去置信图中找到最大置信得分的对应的bbox中心位置,以及先前帧预测的高度和宽度信息,形成了初始的bbox信息。然后通过在bbox里面增加均匀随机的噪声形成了10个初始的proposals,然后使用5个梯度上升的步骤最大化每一个proposal bbox,最终的预测结果采用了具有最高的IoU得分的3个proposals的均值。(作者没有再进行SiamRPN的后处理了)。 这边的调制向量 c ( x 0 , B 0 ) c(x_0,B_0) c(x0,B0)只在第一帧中进行预计算。 (3)难样本挖掘方法 参考了(MDNet,DaSiamRPN)如果在分类得分中检测到了干扰物有peak值,则这次训练的学习率会加倍,而后运行共轭梯度的分类优化。如果最大值得分在0.25以下,同样将训练学习率加倍。

4.Test Process

和上述的在线跟踪一样。

最终将IoU得分最大的测试bbox输出为最终的结果。5.Experiment

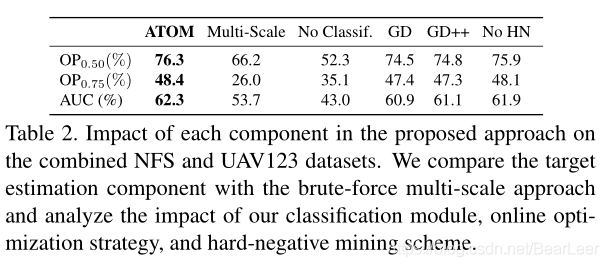

- Ablation Study

1.Multi-Scale(仅有分类模块)和Target Estimation (ATOM) 对比。 2.No Classif. 和Target Classification network (ATOM) 对比。 3.在线跟新方法对比:GD指在线更新采用gradient descent; 4.难样本挖掘:No HN代表不添加难样本挖掘的方法。

1.Multi-Scale(仅有分类模块)和Target Estimation (ATOM) 对比。 2.No Classif. 和Target Classification network (ATOM) 对比。 3.在线跟新方法对比:GD指在线更新采用gradient descent; 4.难样本挖掘:No HN代表不添加难样本挖掘的方法。

6.Conclusion

作者提出了新的跟踪框架,将跟踪任务分为分类任务和状态估计任务(不是之前的回归任务)。然后对分类任务采用在线训练,状态估计任务采用大规模数据集的离线训练。最后采用了在线更新的方法优化分类模块和最大化每一个初始bbox的IoU得分。运行帧率30FPS。

论文:https://arxiv.org/abs/1811.07628

代码:https://github.com/visionml/pytracking

转载地址:https://blog.csdn.net/BearLeer/article/details/115260166 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

能坚持,总会有不一样的收获!

[***.219.124.196]2024年04月13日 17时50分32秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

Unity中使用ViedoPlayer操作视频文件

2019-04-27

C#中的的输入与输出

2019-04-27

C#中@符号的作用

2019-04-27

C#中$符号的作用

2019-04-27

Mac装windows系统后如何更换触控板设置

2019-04-27

Windows系统下如何设置软件的快捷键

2019-04-27

语言中的溢出

2019-04-27

Unity中实现获取一段时间内移动设备声音的最大音量

2019-04-27

springboot的初始化启动过程

2019-04-27

关于spring bean 生命周期代码详解-产生到消亡

2019-04-27

spring 启动之全过程 源码解析

2019-04-27

Spring AOP 原理

2019-04-27

mysql 分库分表分区 动态扩容 总结

2019-04-27

分布式事务 四种方案

2019-04-27

redis和spring整合

2019-04-27

iis6 和iis7s上整个网站重定向

2019-04-27

iis7 url重写和重定向

2019-04-27

navicat工具来将SQL Server数据迁移到MySQL

2019-04-27

XStream xml与javabean之间的互转

2019-04-27