bert中的sep_在属性级情感分析中结合BERT和语法信息

论文: Modelling Context and Syntactical Features for Aspect-based Sentiment Analysis 地址: https://www.aclweb.org/anthology/2020.acl-main.293/ 这是ACL2020上的一篇长文,作者来自澳大利亚伍伦港大学。(感觉wollongong翻译成卧龙岗更带感) 在这篇文章中,作者没有使用一个端到端的模型,而是对属性词抽取(AE)和属性级情感分类(ASC)进行独立的研究。在AE任务中,作者结合了roberta、词法信息和句法信息;在ASC任务中,作者研究了如何在预训练语言中更好地结合句子和属性词。

论文: Modelling Context and Syntactical Features for Aspect-based Sentiment Analysis 地址: https://www.aclweb.org/anthology/2020.acl-main.293/ 这是ACL2020上的一篇长文,作者来自澳大利亚伍伦港大学。(感觉wollongong翻译成卧龙岗更带感) 在这篇文章中,作者没有使用一个端到端的模型,而是对属性词抽取(AE)和属性级情感分类(ASC)进行独立的研究。在AE任务中,作者结合了roberta、词法信息和句法信息;在ASC任务中,作者研究了如何在预训练语言中更好地结合句子和属性词。

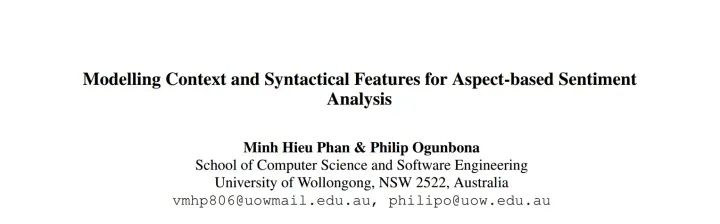

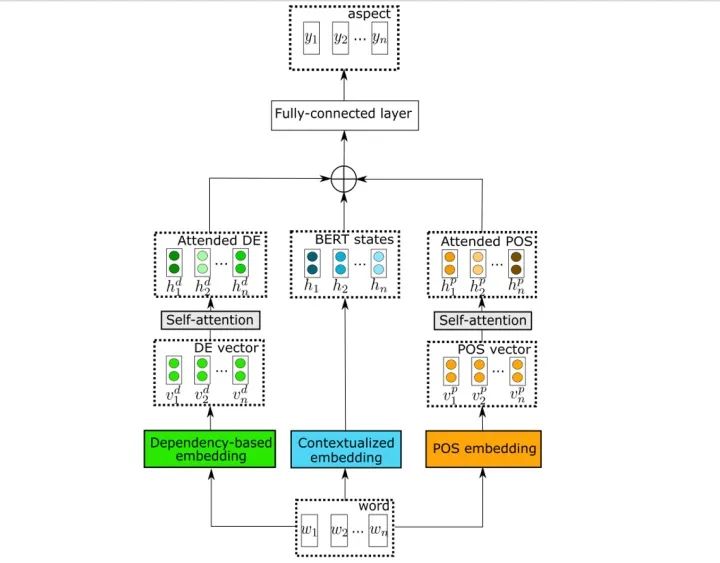

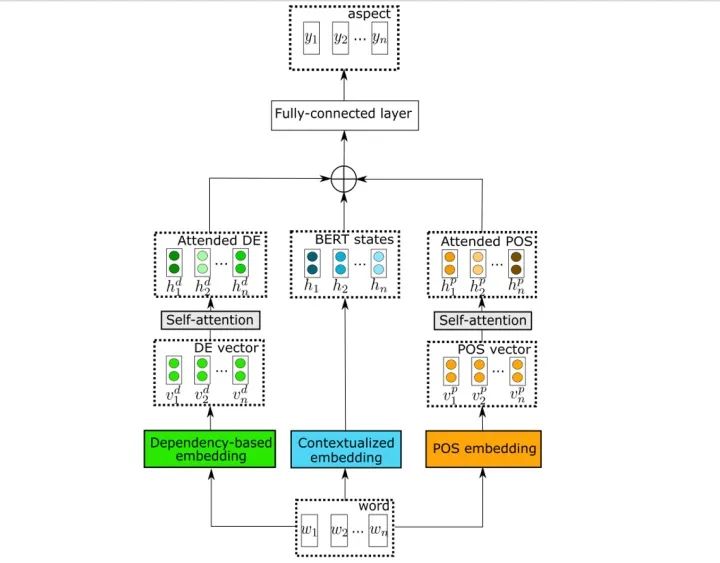

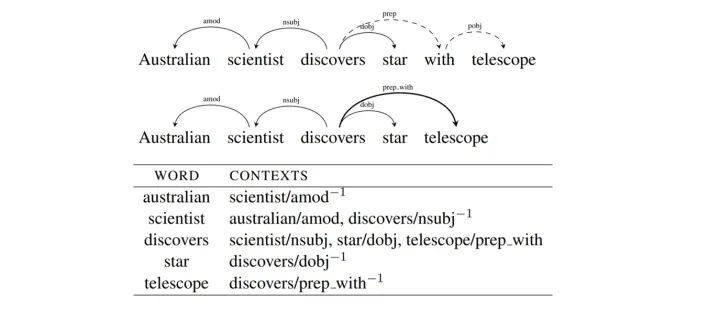

利用词法信息 作者首先通过一个词法分析的工具 [1] 来得到句子对应的词性标签序列,然后通过一个嵌入矩阵将词性转化为向量,接着输入到自注意力层来建模词性之间的依赖关系。这里应该使用了位置嵌入(作者没有提到,但我觉得这里应该是要的)。 利用句法信息 句法信息的利用则是参考了14年的一篇工作 [2] ,这里介绍一下其大致思路。在skip-gram模型中,单词被用来预测上下文,上下文是通过一个窗口确定的;而此工作任务认为应该根据句法关系来确定上下文,作者将这种上下文称为Dependency-Based Contexts。具体来说,首先对给定句子进行句法解析,得到句法解析树,然后将其中的介词和关系进行合并,于是一个单词的Dependency-Based Contexts即为在树中该词的相邻节点和关系。

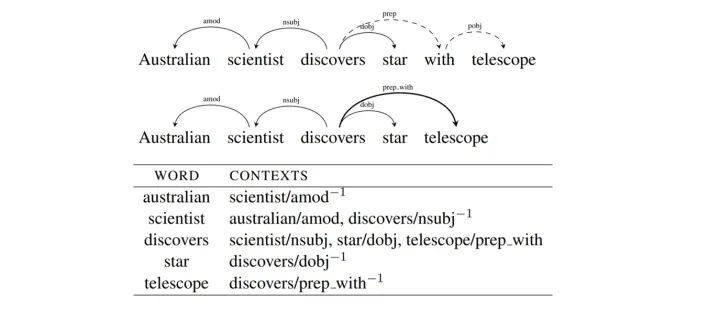

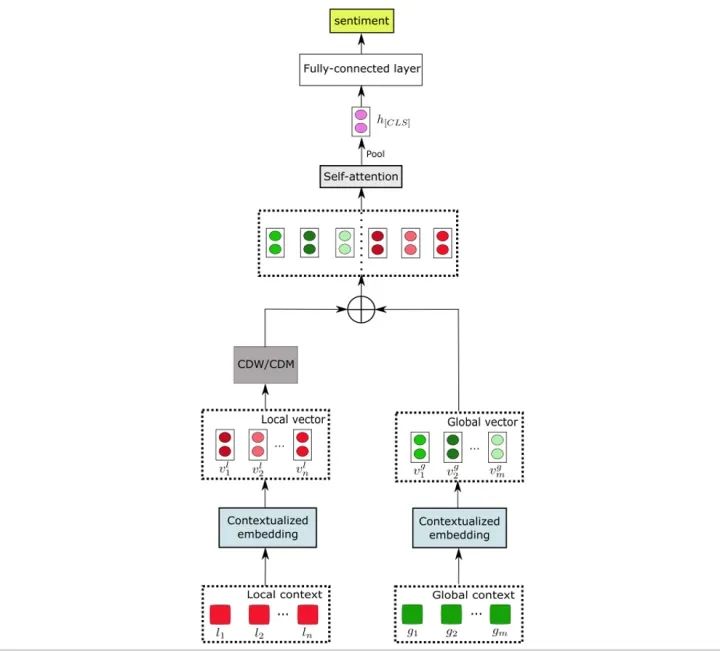

CDM即为context dynamic mask,是指根据与属性词之间的距离来屏蔽句子中的一些单词;而完全屏蔽某些单词可能过于绝对,因此CDW(context dynamic weighting)则是按照与属性词之间的距离为单词赋予一个0到1之间的权重。具体的细节这里不再介绍。 LCFS-ASC即local context focus on syntax - ASC,与LCF-BERT的不同之处在于,在进行CDM/CDW时所使用的单词之间的距离,不再是通过位置计算,而是两个单词在句法解析树中的距离。

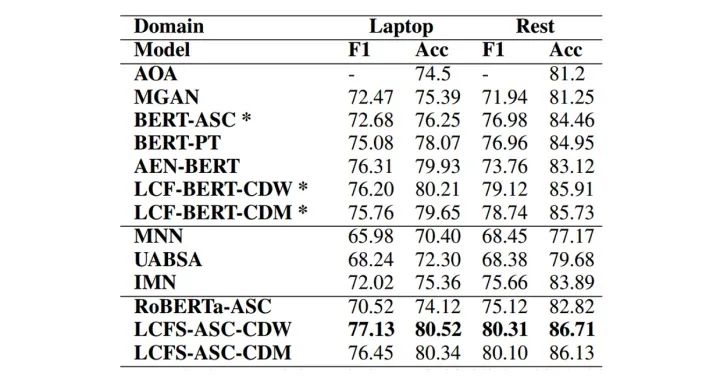

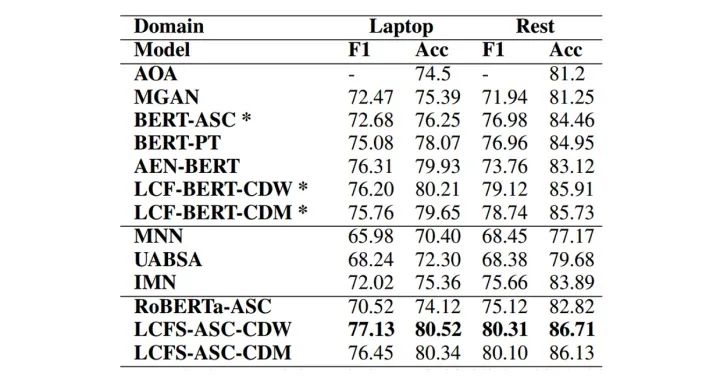

对于ASC任务,如下表所示,使用了LCFS的策略之后,模型性能有了很大的提高,并且CDW优于CDM;LCFS稍微优于LCF。

记得备注呦

记得备注呦

整理不易,还望给个在看!

整理不易,还望给个在看!

发布日期:2021-06-24 15:52:27

浏览次数:2

分类:技术文章

本文共 2751 字,大约阅读时间需要 9 分钟。

点击上方,选择星标或置顶,每天给你送干货 !

!

作者:张义策 学校:哈尔滨工业大学(深圳) 方向:自然语言处理 知乎:https://www.zhihu.com/people/zhang-yi-ce-84阅读大概需要6分钟

跟随小博主,每天进步一丢丢

论文: Modelling Context and Syntactical Features for Aspect-based Sentiment Analysis 地址: https://www.aclweb.org/anthology/2020.acl-main.293/ 这是ACL2020上的一篇长文,作者来自澳大利亚伍伦港大学。(感觉wollongong翻译成卧龙岗更带感) 在这篇文章中,作者没有使用一个端到端的模型,而是对属性词抽取(AE)和属性级情感分类(ASC)进行独立的研究。在AE任务中,作者结合了roberta、词法信息和句法信息;在ASC任务中,作者研究了如何在预训练语言中更好地结合句子和属性词。

论文: Modelling Context and Syntactical Features for Aspect-based Sentiment Analysis 地址: https://www.aclweb.org/anthology/2020.acl-main.293/ 这是ACL2020上的一篇长文,作者来自澳大利亚伍伦港大学。(感觉wollongong翻译成卧龙岗更带感) 在这篇文章中,作者没有使用一个端到端的模型,而是对属性词抽取(AE)和属性级情感分类(ASC)进行独立的研究。在AE任务中,作者结合了roberta、词法信息和句法信息;在ASC任务中,作者研究了如何在预训练语言中更好地结合句子和属性词。 CSAE:在AE中结合语法信息

作者将结合语法信息的AE任务称为CSAE(contextualized syntax-based AE)。在AE中使用语法信息的工作有很多,但是结合了预训练语言模型的倒是头次见。 如下图所示,句子的表示由三部分构成,分别是BERT的输出、由词法信息得到的表示和由句法信息得到的表示。得到句子的表示后,通过一个全连接层来预测相应的BIO字标签。下面分别介绍如何编码词法信息和句法信息。

LCFS-ASC:在ASC更好地结合句子和属性词

最早在naacl19上有两篇工作在ASC任务中使用BERT,他们都是将句子和属性词拼接在一起送入到BERT模型中。但考虑到属性词是出现在BERT模型中的,这样的做法会有一些不妥。因此,还是在19年,有研究者提出了LCF-BERT [3] 。 这篇文章所提出的LCFS-ASC和LCF-BERT的思路基本相同。 不妨记句子为S,属性词为A。称[CLS]+S+[SEP]+A+[SEP]为global context,而[CLS]+S+[SEP]为local context。如下图所示,将二者分别输入到BERT模型中进行编码。为了在local context引入属性词的信息,LCF-BERT中提出了两种方法(CDM/CDW)进行Local Context Focus(LCF)。下面简单介绍一下CDW和CDM。

实验及分析

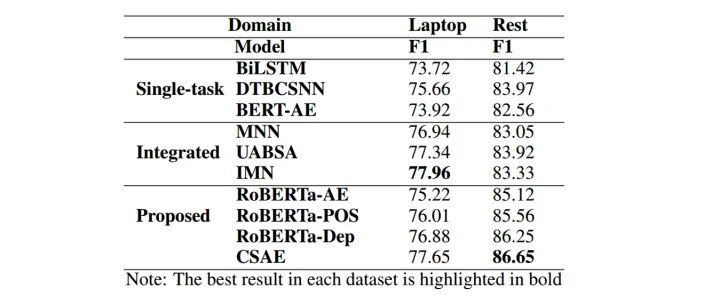

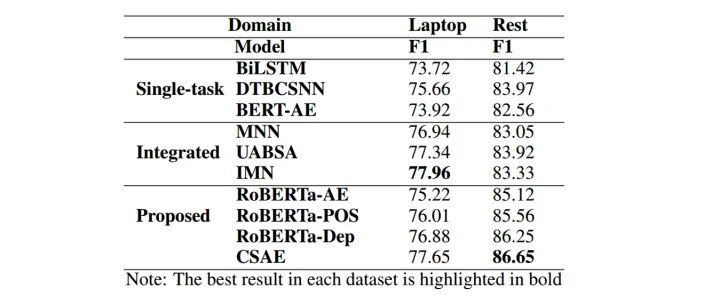

作者仅在semeval-14的ABSA数据集上进行了实验。如下表所示,使用了词法信息和句法信息后,f1值有了较大的提升(CSAE>RoBERTa-AE),句法信息带来的提升更加明显(RoBERTa-Dep>RoBERTa-POS)。

说个正事哈

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方“深度学习自然语言处理”,进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心 。

。

参考

1. Universal POS tags https://universaldependencies.org/u/pos/ 2. Omer Levy and Yoav Goldberg. 2014. Dependencybased word embeddings. In Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers), pages 302–308. https://www.aclweb.org/anthology/P14-2050/ 3. Biqing Zeng, Heng Yang, Ruyang Xu, Wu Zhou, and Xuli Han. 2019. Lcf: A local context focus mechanism for aspect-based sentiment classification. Applied Sciences, 9(16):3389. https://www.researchgate.net/publication/335238076_LCF_A_Local_Context_Focus_Mechanism_for_Aspect-Based_Sentiment_Classification 投稿或交流学习,备注: 昵称-学校(公司)-方向,进入DL&NLP交流群。 方向有很多: 机器学习、深度学习,python,情感分析、意见挖掘、句法分析、机器翻译、人机对话、知识图谱、语音识别等。 记得备注呦

记得备注呦 推荐两个专辑给大家:

专辑 | 李宏毅人类语言处理2020笔记

专辑 | NLP论文解读

整理不易,还望给个在看!

整理不易,还望给个在看! 转载地址:https://blog.csdn.net/weixin_33673142/article/details/112230544 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

不错!

[***.144.177.141]2024年04月07日 21时35分02秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

git常用命令

2019-04-28

车道线检测论文汇总

2019-04-28

语义分割之IS-Triplet loss

2019-04-28

一句话总结YoloF

2019-04-28

语义分割之网络结构

2019-04-28

KITTI数据集raw_data标定文件说明

2019-04-28

Android 压缩视频传输

2019-04-28

Android 实时视频压缩传输(720P)

2019-04-28

Ubuntu历史版本下载地址

2019-04-28

linux vi编辑器使用总结

2019-04-28

Android 开发环境搭建 (Android Studio)

2019-04-28

Linux 共享库加载方法

2019-04-28

linux 搜索命令总结

2019-04-28

Snapdragon Flight WIFI模式

2019-04-28

Snapdragon Flight 登陆方式

2019-04-28

Ubuntu linux 添加动态链接库路径

2019-04-28

Snapdragon Flight 刷机教程

2019-04-28

Snapdragon Flight AP模式下,查看当前连接到热点的设备

2019-04-28

Snapdragon Flight 通过ssh 远程root 登录

2019-04-28

GCC编译C/C++代码

2019-04-28