GBDT与XGBoost

发布日期:2021-06-29 18:48:49

浏览次数:2

分类:技术文章

本文共 476 字,大约阅读时间需要 1 分钟。

文章目录

GBDT与XGBoost

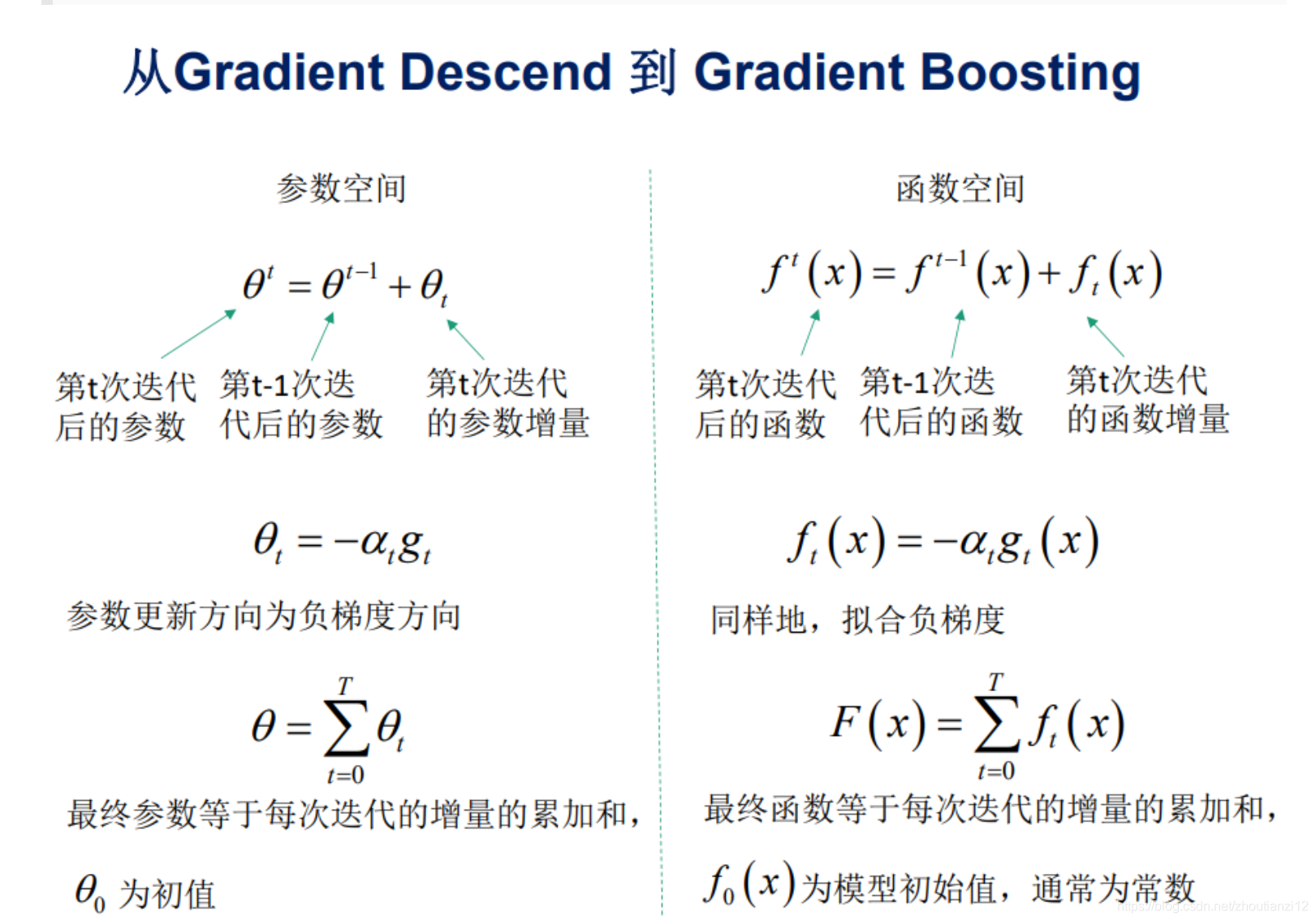

- 介绍过梯度下降法与牛顿法,

- GBDT与XGBoost就与这两种方法有关

- boosting(GBDT、XGBoost)是一个加法模型

- 可解释性强

- 可处理混合类型特征

- 具体伸缩不变性(不用归一化特征)

- 有特征组合的作用

- 可自然地处理缺失值

- 对异常点鲁棒

- 有特征选择作用

- 可扩展性强,容易并行 缺点:

- 缺乏平滑性(回归预测时输出值只能输出有限的若干种数值)

- 不适合处理高维稀疏数据

一、GBDT

- 泛指所有梯度提升树算法,

- XGBoost,是GBDT的一种变种,

- 为区分,

- GBDT一般特指“Greedy Function Approximation:A Gradient Boosting Machine”里提出的算法,

- 只用了一阶导数信息。

- GBDT是在函数空间上利用梯度下降优化

- GBDT是多个弱分类器合成强分类器的过程(加权求和),

- 每次迭代产生一个弱分类器,

- 当前弱分类器是在之前分类器残差基础上训练。

- 目标:损失函数尽可能快减小,

- 则让损失函数沿着梯度方向下降。

- –> gbdt 的gb的核心了。

canci

转载地址:https://cyj666.blog.csdn.net/article/details/106822119 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

路过按个爪印,很不错,赞一个!

[***.219.124.196]2024年04月07日 15时29分08秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

Mac电脑使用:Mac电脑查看本机的IP和公网IP的方法

2019-04-30

NOI 2020 解题报告

2019-04-30

一道神奇的几何题

2019-04-30

【UR #5】怎样跑得更快 题解

2019-04-30

二分图经典技巧

2019-04-30

P5292 [HNOI2019 D2T1]校园旅行 总结

2019-04-30

CF1536F Omkar and Akmar 题解

2019-04-30

CF1540D Inverse Inversions 题解

2019-04-30

AGC054 题解(A-C)

2019-04-30

LOJ NOI Round #1,#2 好题怒补

2019-04-30

小胖虎带你了解MySQL 数据库基础

2019-04-30

菜鸟笔记八:内嵌框架属性:iframe

2019-04-30

菜鸟笔记九:video

2019-04-30

vue面试题一

2019-04-30

vue面试题二

2019-04-30

vue面试题四

2019-04-30

菜鸟笔记十:选择器

2019-04-30

菜鸟笔记十一:flex布局

2019-04-30