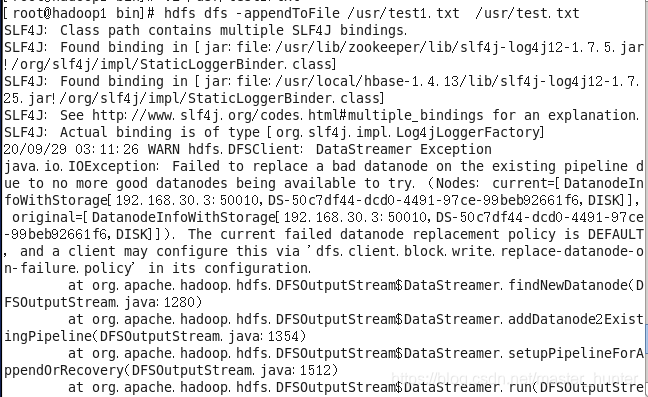

HDFS使用appendToFile报错WARN hdfs.DFSClient: DataStreamer Exception java.io.IOException: Failed

发布日期:2021-06-30 15:41:17

浏览次数:3

分类:技术文章

本文共 666 字,大约阅读时间需要 2 分钟。

报错提示说原文件已经被视为bad datanode了,具体不知道怎么被视作的。参考hadoop错误解决方案:

先看看文件是否有写权限。

![]()

往空文件中追加就相当于直接写文件,所以能追加进去,而往有内容的文件中追加不进去是因为datanode节点数不够三个,其他虚拟机没有开无法进行文件备份。

解决方法1:

至少打开三个节点。

解决方法2:

修改hdfs-site.xml文件,添加或者修改如下两项: < property> < name> dfs.client.block.write.replace-datanode-on-failure.enable </ name> < value>true</ value> </ property> < property> < name> dfs.client.block.write.replace-datanode-on-failure.policy </ name> < value>never</ value> </ property> 添加或修改完成后,重试即可。解决方法3:

在客户端的代码里面加入:

conf = new Configuration();

conf.set("dfs.client.block.write.replace-datanode-on-failure.policy", "NEVER" );conf.set("dfs.client.block.write.replace-datanode-on-failure.enable",

"true" );转载地址:https://jxnuxwt.blog.csdn.net/article/details/108864159 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

很好

[***.229.124.182]2024年04月16日 18时35分17秒

关于作者

喝酒易醉,品茶养心,人生如梦,品茶悟道,何以解忧?唯有杜康!

-- 愿君每日到此一游!

推荐文章

反向传播&梯度下降 的直观理解程序(numpy)

2019-04-30

CodeForces - 931B World Cup (思维 模拟)

2019-04-30

ACM 2017 北京区域赛 J-Pangu and Stones(区间dp)

2019-04-30

java常用类 String面试题

2019-04-30

Windows10下的powershell美化教程

2019-04-30

利用ffmpeg合并音频和视频

2019-04-30

solr修改schema文件(solr修改配置文件)

2019-04-30

select下拉框分组展示插件的使用--(select-mania插件的使用)

2019-04-30

Java Lambda表达式的应用--Stream API操作集合框架

2019-04-30

Myslq连接(JDBC)url属性的参数的设置

2019-04-30

关于Spring MVC与前端的交互

2019-04-30

大厂经典面试题:Redis为什么这么快?

2019-04-30

Android之Retrofit基本用法篇

2019-04-30

Netty与网络协议资料整理

2019-04-30

Golang 逃逸分析

2019-04-30

golang实现大数据量文件的排序

2019-04-30

golang中的time包

2019-04-30