本文共 2581 字,大约阅读时间需要 8 分钟。

In , the Hessian matrix is the of second-order of a; that is, it describes the local curvature of a function of many variables. The Hessian matrix was developed in the 19th century by the mathematician and later named after him. Hesse himself had used the term "functional determinants".

海森矩阵就是二阶偏导函数的方阵.他描述了局部的曲率函数.

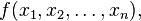

Given the -valued function

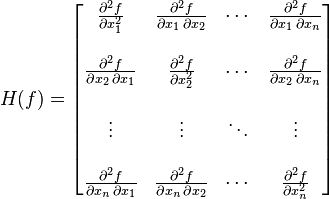

if all second partial derivatives of f exist, then the Hessian matrix of f is the matrix

where x = (x1, x2, ..., xn) and Di is the differentiation operator with respect to the ith argument and the Hessian becomes

Some mathematicians define the Hessian as the of the above matrix.

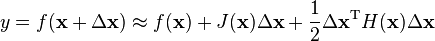

Hessian matrices are used in large-scale problems within -type methods because they are the coefficient of the quadratic term of a local of a function. That is,

where J is the , which is a vector (the ) for scalar-valued functions. The full Hessian matrix can be difficult to compute in practice; in such situations, algorithms have been developed that use approximations to the Hessian. The most well-known quasi-Newton algorithm is the algorithm.

如果

H(f)ij(x)  ,即

,即

可见,多元函数的二阶导数就是一个海森矩阵 海森矩阵被应用于牛顿法解决的大规模优化问题。

混合偏导数和海森矩阵的对称性

海森矩阵的混合偏导数是海森矩阵非主对角线上的元素。假如他们是连续的,那么求导顺序没有区别,即

上式也可写为

在正式写法中,如果

给定二阶导数连续的函数 ,海森矩阵的行列式,可用于分辨

,海森矩阵的行列式,可用于分辨

对于  ,然而凭一阶导数不能判断它是鞍点、局部极大点还是局部极小点。海森矩阵可能解答这个问题。

,然而凭一阶导数不能判断它是鞍点、局部极大点还是局部极小点。海森矩阵可能解答这个问题。

,则(x0,y0)是局部极小点;若

,则(x0,y0)是局部极小点;若 ,则(x0,y0)是局部极大点。

,则(x0,y0)是局部极大点。

MATLAB中获得Hessian矩阵:

The

首先类比一下一维。Jacobian相当于一阶导数,Hessian相当于二阶导数。

转载地址:https://panda1234lee.blog.csdn.net/article/details/9472997 如侵犯您的版权,请留言回复原文章的地址,我们会给您删除此文章,给您带来不便请您谅解!

发表评论

最新留言

关于作者